웹사이트 운영자라면 한 번쯤 마주하게 되는 구글 서치콘솔과 페이지스피드 인사이트의 빨간 경고등. 최근 저도 robots.txt 유효성 오류와 REST API 403 Forbidden 문제를 해결하며 진땀을 뺐습니다.

우선 저는 워드프레스에서 클라우드플레어에 연동한 뒤 AI봇 차단이 문제가 되었느데요 이에 클라우드플레어(Cloudflare)와 워드프레스 환경에서 발생하는 주요 기술적 오류들을 어떻게 완벽하게 해결했는지, 그 과정과 최적화 코드를 공유해 드립니다.

📌 주요 해결 내용 요약

- ✅ robots.txt Unknown directive: 클라우드플레어 비표준 지시어 제거 및 표준화

- ✅ REST API 403 Forbidden: 서버 루프백 통신 및 PHP 핸들러 버전 충돌 수정

- ✅ AI 봇 차단: GPTBot, Google-Extended 등 최신 AI 크롤러 완벽 차단

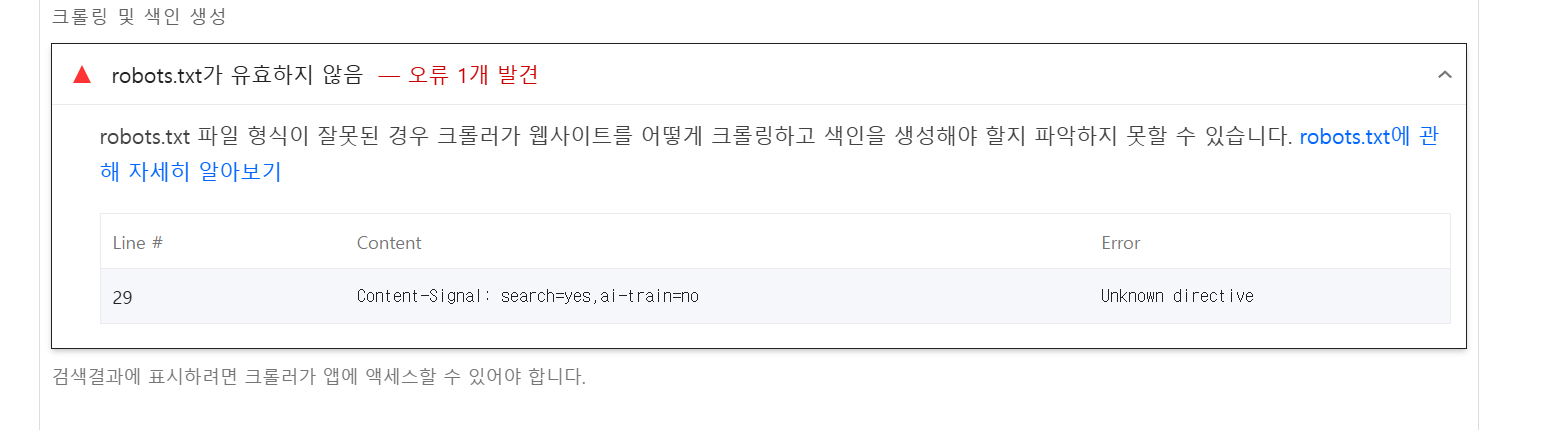

1. robots.txt 유효하지 않음 (Unknown directive) 해결

구글 페이지스피드 검사에서 robots.txt 파일의 29번 라인 등에 오류가 뜨는 경우가 있습니다.

이는 주로 클라우드플레어의 '콘텐츠 신호 정책' 기능이 비표준 문구를 강제로 삽입하기 때문입니다.

💡 해결 방법

- 클라우드플레어 설정 변경: [Security] > [Bots] 메뉴에서 'robots.txt 구성 사용 중지'를 선택합니다.

- 표준 문법 적용: 아래와 같이 구글이 이해할 수 있는 표준 문법으로 AI 봇을 차단해야 합니다.

User-agent: GPTBot

Disallow: /

User-agent: Google-Extended

Disallow: /

User-agent: *

Allow: /

2. REST API 403 Forbidden 오류 조치

워드프레스 '사이트 건강' 메뉴에서 REST API 응답이 403으로 뜬다면, 서버 내부 통신이 보안 규칙에 의해 막혀있을 가능성이 99%입니다.

💡 해결 방법

.htaccess 파일에서 핫링크 방지(Hotlink Protection)나 봇 차단 코드를 점검해야 합니다.

특히 PHP 버전 핸들러가 현재 서버 사양(예: PHP 8.3)과 일치하는지 반드시 확인하세요.

3. 검색 엔진 크롤링 최적화 (가독성 개선)

<a href="javascript:void(0)">와 같은 코드는 검색 엔진 로봇이 길을 잃게 만듭니다.

기능을 수행하는 요소는 <button> 태그로 교체하여 접근성과 SEO 점수를 동시에 잡아야 합니다.

✅ 해결 후기 결과는 어떨까?

모든 설정을 마치고 클라우드플레어의 Purge Everything(캐시 전체 삭제)과 워드프레스 Redis 캐시 제거를 진행했습니다.

결과는 대성공이었습니다.

- 서치콘솔 오류 해결: 며칠 뒤 확인 결과 유효하지 않은 robots.txt 경고가 사라졌습니다.

- 페이지 성능 향상: 비표준 코드를 제거하고 태그를 최적화하니 Lighthouse 점수가 눈에 띄게 개선되었습니다.

기술적인 오류는 방치할수록 검색 순위에 악영향을 미칩니다. 혹시 비슷한 문제로 고민 중이시라면 위 가이드대로 설정을 점검해 보시길 권장합니다!

'IT 리뷰 > 블로그 SEO' 카테고리의 다른 글

| 워드프레스 & WHM 보안 서치콘솔 오류부터 외부 유입 차단까지 (0) | 2026.02.12 |

|---|---|

| 멀티 서버 세션 저장소는 왜 Redis 많을까? Memcached 비교로 정리 (0) | 2026.02.11 |

| WHM(EasyApache 4) PHP 8.4 OPcache + Redis Object Cache 구성 장애 복구후기 (0) | 2026.02.10 |